By ribbon @

2021-04-06 17:15

前回は D でしたが、今回は Q です。Qt関連のパッケージが多く存在していました。

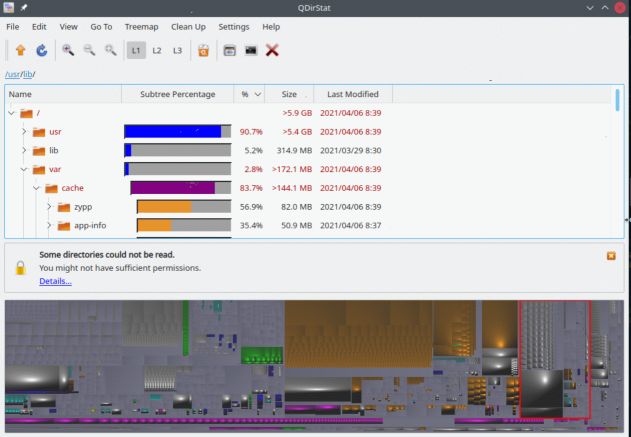

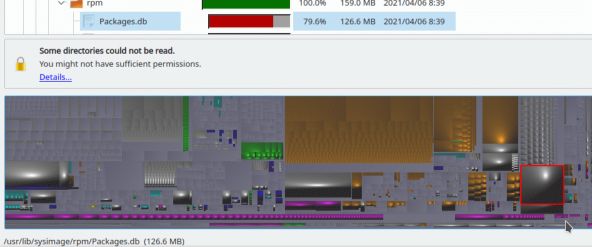

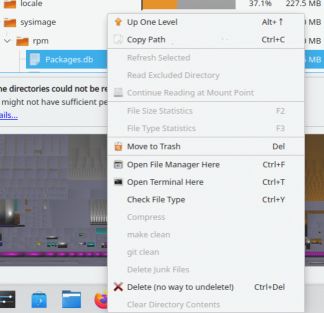

パッケージ名 qdirstat

面白いのは、下部に表示されている図で、これは、各ファイルの大きさをベースにしたイメージです。例えば、ある大きな模様の所をクリックすると、そのイメージに対応するファイルに移動することが出来ます。

さらに、右クリックで種々の操作を選ぶことも出来ます。

qdirstat は、ディレクトリを渡りながら、ディスクの掃除をするときなどに便利に使えそうです。

Category

openSUSE ,

Tips ,

その他 ,

デスクトップ ,

未分類 |

受け付けていません

By ribbon @

2021-04-04 12:43

前回は O でしたが今回は Dです。

パッケージ名 datefudge

% date

2021年 4月 3日 土曜日 22:09:35 JST

% datefudge "2007-04-01 10:23" date

2007年 4月 1日 日曜日 10:23:00 JST

% datefudge "2 weeks ago" date

2021年 3月 20日 土曜日 22:11:39 JSTさらに、 –static オプションというのがあり、これを使うと、日付を固定してしまうことが出来ます。

% datefudge "2007-04-01 10:23" sh -c "sleep 3; date"

2007年 4月 1日 日曜日 10:23:03 JST

% datefudge --static "2007-04-01 10:23" sh -c "sleep 3; date"

2007年 4月 1日 日曜日 10:23:00 JSTこのように、3秒後でも時刻が変わっていません。

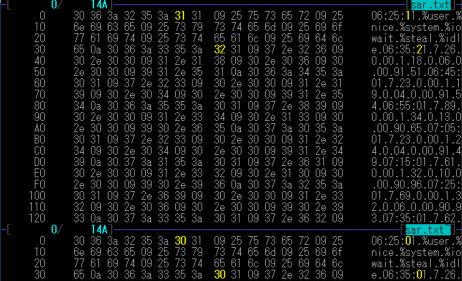

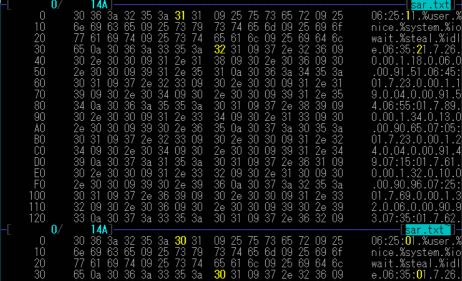

パッケージ名 datamash

%cat sar.txt

06:25:01 %user %nice %system %iowait %steal %idle

06:35:01 7.26 0.00 1.18 0.06 0.00 91.51

06:45:01 7.23 0.00 1.19 0.04 0.00 91.54

06:55:01 7.89 0.00 1.34 0.13 0.00 90.65

07:05:01 7.23 0.00 1.24 0.04 0.00 91.49

07:15:01 7.61 0.00 1.32 0.10 0.00 90.96

07:25:01 7.69 0.00 1.32 0.06 0.00 90.93

07:35:01 7.62 0.00 1.31 0.05 0.00 91.02となっているファイルの縦横は、

% datamash transpose <sar.txt

06:25:01 06:35:01 06:45:01 06:55:01 07:05:01 07:15:01 07:25:01 07:35:01

%user 7.26 7.23 7.89 7.23 7.61 7.69 7.62

%nice 0.00 0.00 0.00 0.00 0.00 0.00 0.00

%system 1.18 1.19 1.34 1.24 1.32 1.32 1.31

%iowait 0.06 0.04 0.13 0.04 0.10 0.06 0.05

%steal 0.00 0.00 0.00 0.00 0.00 0.00 0.00

%idle 91.51 91.54 90.65 91.49 90.96 90.93 91.02と言うように変換できます。また、2列目の合計と平均を出すには、

% tail -n +2 sar.txt |datamash sum 2 mean 2

52.53 7.5042857142857とします(最初の1行が非数値を含む行なのでスキップしています)。

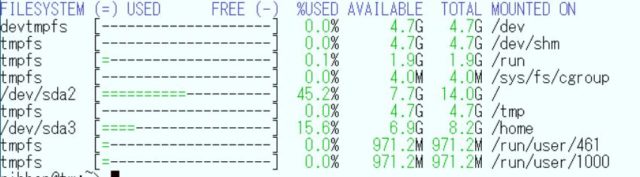

パッケージ名 dfc

% df

ファイルシス 1K-ブロック 使用 使用可 使用% マウント位置

devtmpfs 4961412 0 4961412 0% /dev

tmpfs 4972560 0 4972560 0% /dev/shm

tmpfs 1989028 1172 1987856 1% /run

tmpfs 4096 0 4096 0% /sys/fs/cgroup

/dev/sda2 14669824 6630060 8039764 46% /

tmpfs 4972564 0 4972564 0% /tmp

/dev/sda3 8581120 1338444 7242676 16% /home

tmpfs 994512 16 994496 1% /run/user/461

tmpfs 994512 12 994500 1% /run/user/1000

の時に、のように表示されます。また、dfc にはいくつかオプションがあり、

% dfc -e csv

FILESYSTEM,%USED,AVAILABLE,TOTAL,MOUNTED ON

devtmpfs,0%,4.7G,4.7G,/dev

tmpfs,0%,4.7G,4.7G,/dev/shm

tmpfs,0%,1.9G,1.9G,/run

tmpfs,0%,4.0M,4.0M,/sys/fs/cgroup

/dev/sda2,45%,7.7G,14.0G,/

tmpfs,0%,4.7G,4.7G,/tmp

/dev/sda3,16%,6.9G,8.2G,/home

tmpfs,0%,971.2M,971.2M,/run/user/461

tmpfs,0%,971.2M,971.2M,/run/user/1000というように、csv 形式で表示させることも出来ます。そのほか、html,json,tex 形式でも出力させることが出来ます。これは、出力結果を何らかの形で加工したり、そのまま表示させるようなときに便利です。

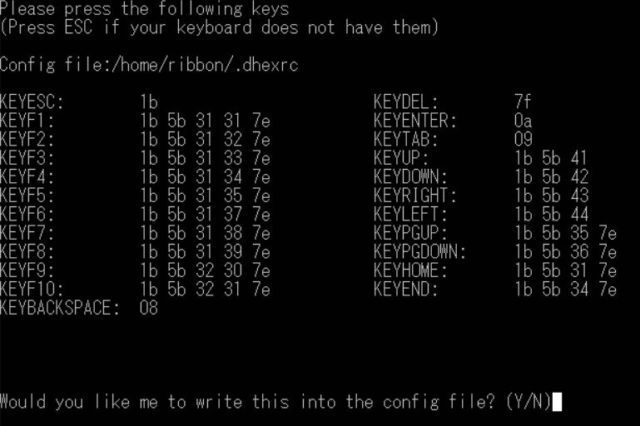

パッケージ名 dhex

下記の画面が、キーの定義をした後の画面です。先に定義したカーソルキーで自由にカーソルを動かすことが出来ます。カーソル位置の値は直接書き換えることが可能です。

また、2つのファイルのバイナリ比較をすることも出来ます。

dhex は ちょっとしたデータの修正や結果の比較などに使うのであれば便利に使えそうです。

パッケージ名 dhtest

# dhtest -i ens18 -L 180

DHCP discover sent - Client MAC : 4a:23:a6:ba:3a:b1

DHCP offer received - Offered IP : 192.168.3.214

DHCP request sent - Client MAC : 4a:23:a6:ba:3a:b1

DHCP ack received - Acquired IP: 192.168.3.214DHCP サーバのテストをするときに覚えておくと良いかもしれません。

Category

openSUSE ,

Tips ,

デスクトップ |

受け付けていません

By ribbon @

2021-03-26 20:45

前回は B でしたが今回は O です。

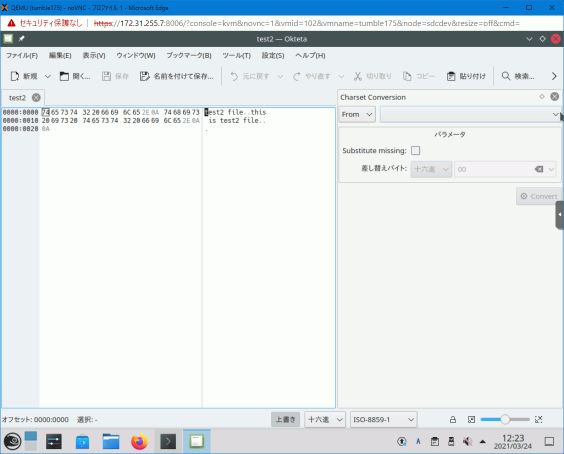

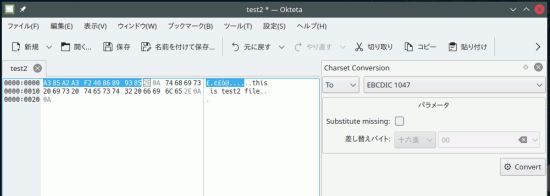

パッケージ名 okteta

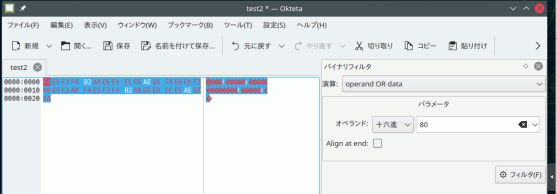

左側にファイルの内容を表示、右側に処理機能といようになっています。処理機能は色々選ぶことができ、選ぶと1つのウィンドウが表示されます。複数表示することもできます。

また、バイト単位のバイナリ演算をすると、たとえば各バイトの最上位に1を立てる(ハイビット ON)ということもできます。ただ、フォント設定がうまくないのか、1バイトかな文字は表示されませんでした。

バイナリ編集は、左側の画面で、テキストエディタと同じように、なぞってコピーや削除を選べば編集できます。データを追加するときには、メニューで、挿入を選べば、文字のパターンやランダムデータなどで入力できます。

okteta はいくつかの処理がプリセットされていて、適合する処理があればかなり便利に使えそうです。ただ、文字コードの変換対象に UTF-8 が無いので、文字コードの変換に使うには、あまり希望に添わないかもしれません。

Category

openSUSE ,

Tips ,

その他 ,

デスクトップ |

受け付けていません

By ribbon @

2021-03-22 15:22

前回は G でしたが、今回は B です。

パッケージ名 batshttp://bbe-.sourceforge.net/bbe.html#bbe-programs に例がありますが、

echo “The quick brown fox jumps over a lazy dog” | bbe -b “/The/:21” -e “j 4” -e “s/ /X/”

を実行すると

The quickXbrownXfoxXjumps over a lazy dog

と言う結果が得られます。まず、処理ブロックとして “The” という文字列から21文字目までを対象とし、さらに、 “j” から4文字は対象外とし、そののち、空白を大文字の “X” に置き換えるという動作をします。また、

echo “The quick brown fox jumps over a lazy dog” | bbe -b “:5” -e “A XYZ”

は5バイトのブロックを定義し、そのブロックの後に “XYZ” という文字列を付加します。

The qXYZuick XYZbrownXYZ fox XYZjumpsXYZ overXYZ a laXYZzy doXYZg

バイト位置を考えねばならない文字列変換を行うときには便利に使えそうです。

パッケージ名 bing

% bing localhost www.opensuse.org

BING localhost (127.0.0.1) and proxy-nue.opensuse.org (195.135.221.140)

44 and 108 data bytes

1024 bits in 3.896ms: 262834bps, 0.003805ms per bit

1024 bits in 0.000ms

1024 bits in 0.090ms: 11377778bps, 0.000088ms per bit

1024 bits in 0.000ms

^C

--- localhost statistics ---

bytes out in dup loss rtt (ms): min avg max

44 1275 1275 0% 0.037 0.057 0.160

108 1275 1275 0% 0.017 0.025 0.126

--- proxy-nue.opensuse.org statistics ---

bytes out in dup loss rtt (ms): min avg max

44 1275 1274 0% 241.446 244.020 402.245

108 1274 1273 0% 241.444 244.103 329.752

--- estimated link characteristics ---

warning: rtt big host1 0.017ms < rtt small host2 0.037ms

warning: rtt big host2 241.444ms < rtt small host2 241.446ms

minimum delay difference is zero, can't estimate link throughput.

Category

openSUSE ,

Tips ,

その他 |

受け付けていません

By ribbon @

2021-03-18 11:13

前回は K でしたが、今回は G です。GAP 、GPS 関連のパッケージが多数ありました。ただ、取り上げられそうなものはあまりなく、1つだけです。

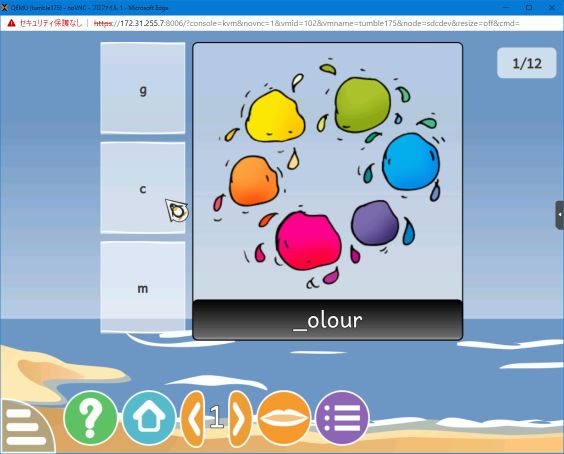

パッケージ名 Gcompris

Category

openSUSE ,

Tips ,

その他 ,

デスクトップ |

受け付けていません

By ribbon @

2021-03-17 11:33

前回 は X でしたが、今回は K です。Kは、KDE関係が多いようです。そのほかに、kubernetes や kopano というツール群のファイルもかなりあります。

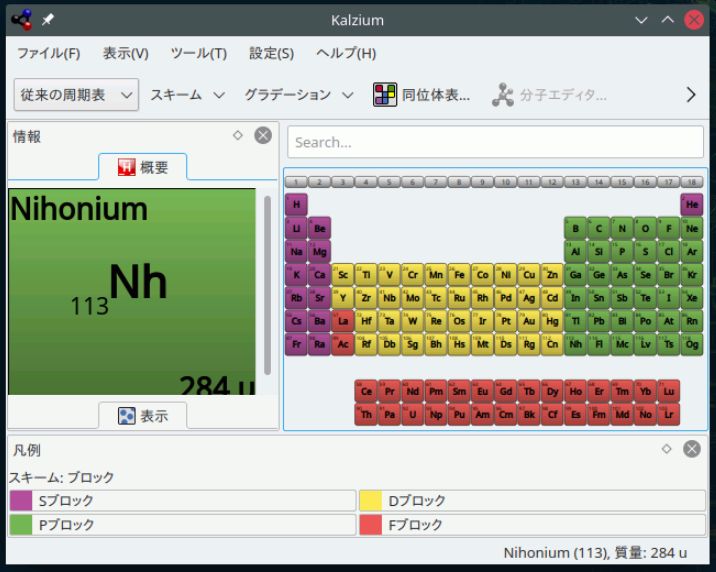

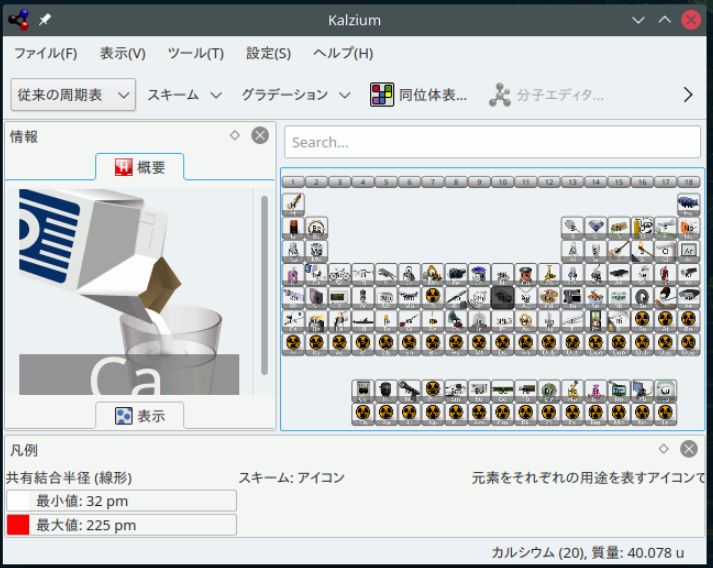

パッケージ名 kalzium

元素データの概要を表示することも出来ます。

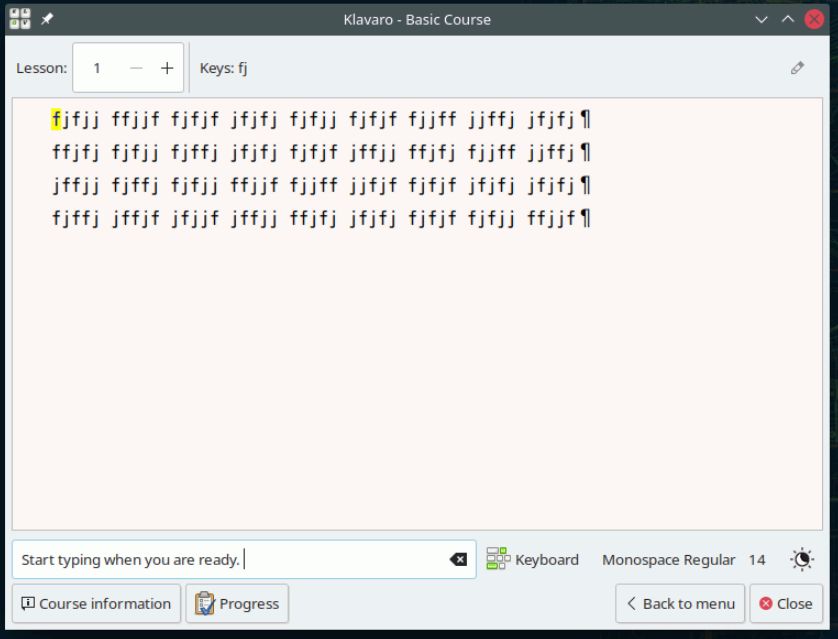

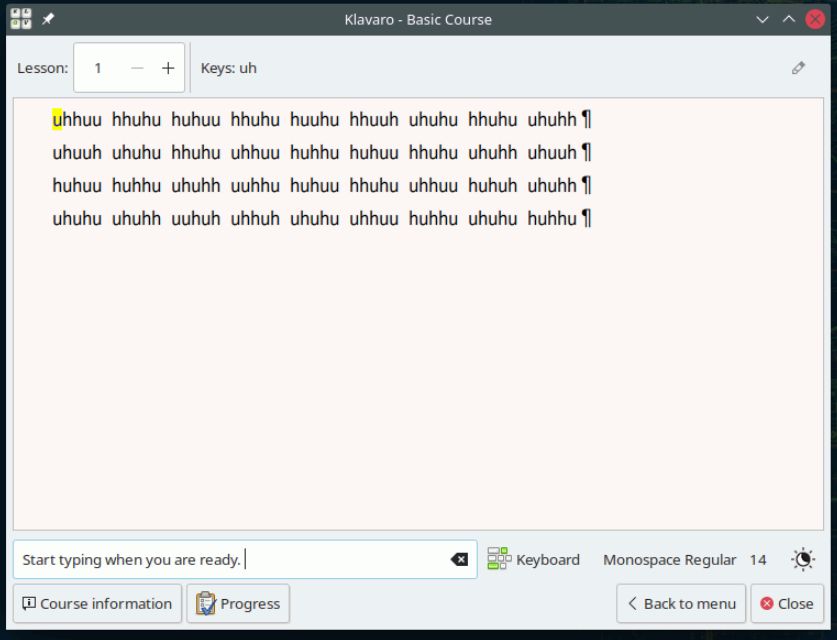

パッケージ名 klavalo

日本語キーボードにも対応しています。特殊記号の位置が正しい場所に来ます。

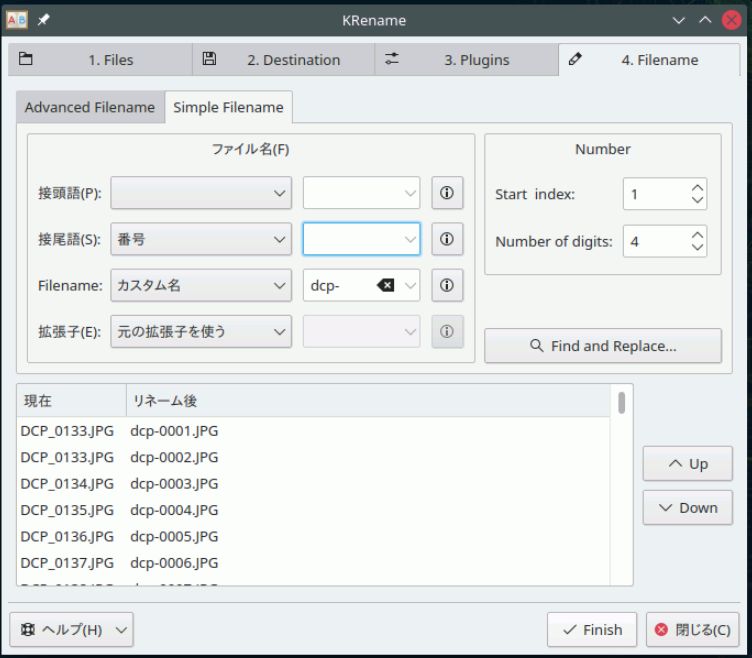

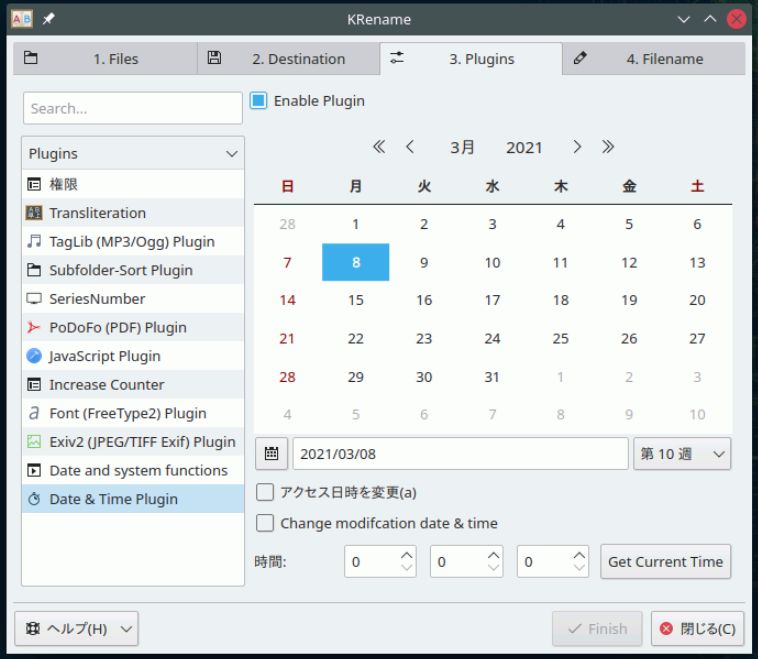

パッケージ名 krename

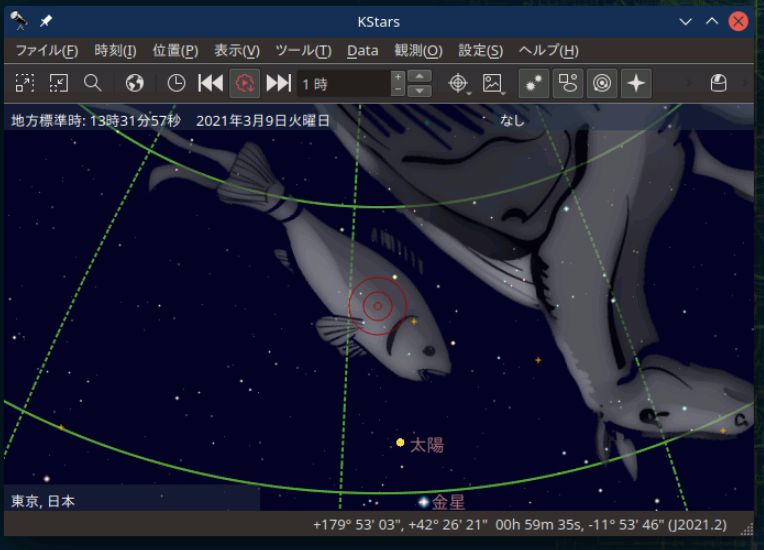

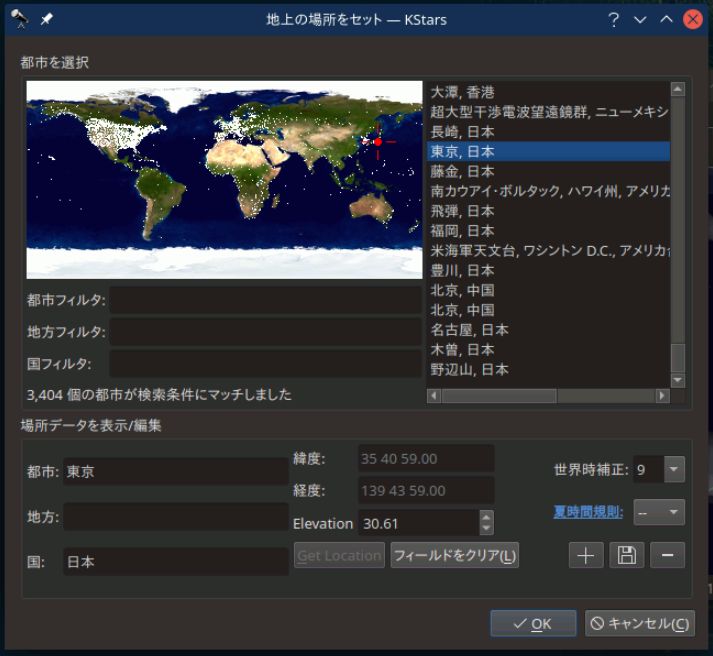

パッケージ名 kstars

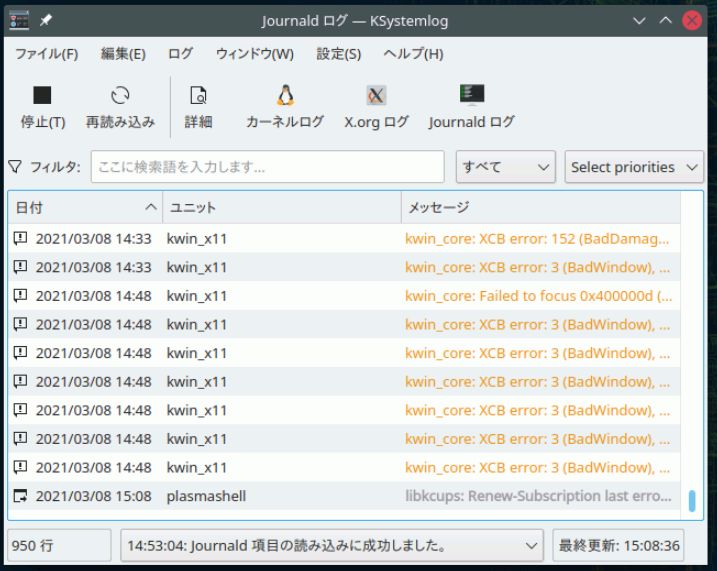

パッケージ名 ksystemlog

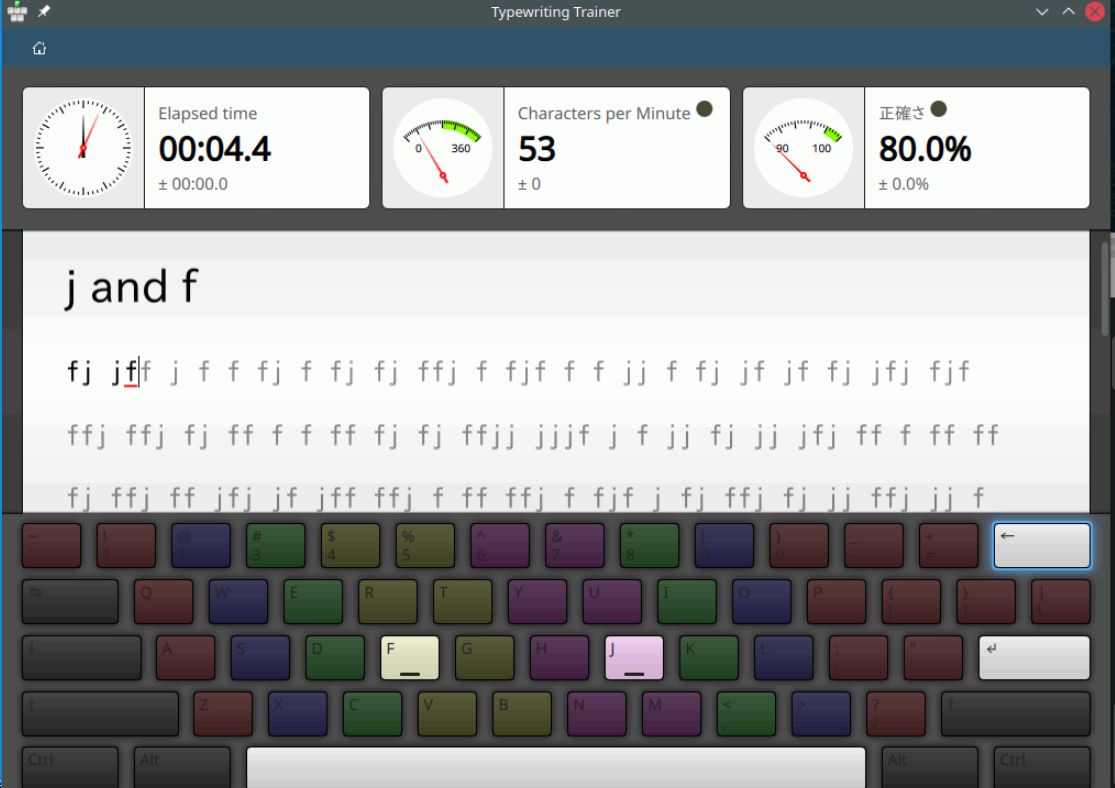

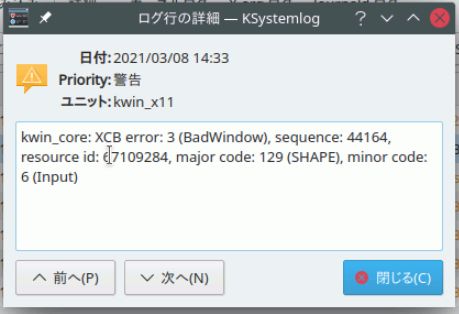

パッケージ名 ktouch

Category

openSUSE ,

Tips ,

その他 ,

デスクトップ |

受け付けていません

By ribbon @

2021-03-15 09:28

前回 は I でしたが、今回は X です。

パッケージ名 xfishtank

パッケージ名 xpra

Category

openSUSE ,

Tips ,

その他 |

受け付けていません

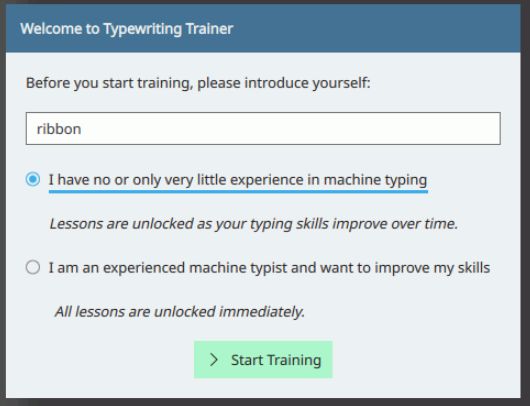

いくつかコースは予め用意されています。

いくつかコースは予め用意されています。