By ribbon @

2021-03-18 11:13

前回は K でしたが、今回は G です。GAP 、GPS 関連のパッケージが多数ありました。ただ、取り上げられそうなものはあまりなく、1つだけです。

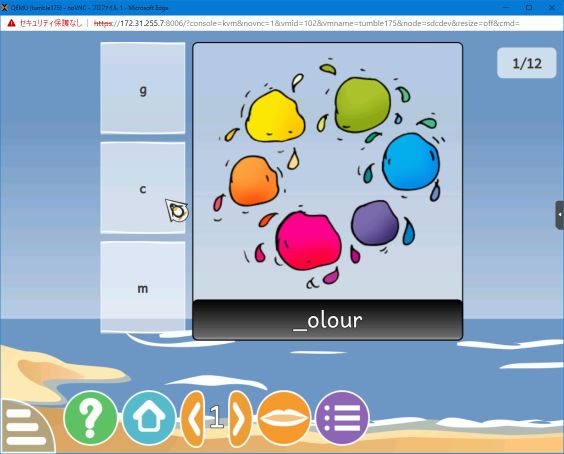

パッケージ名 Gcompris

Category

openSUSE ,

Tips ,

その他 ,

デスクトップ |

受け付けていません

By ribbon @

2021-03-17 11:33

前回 は X でしたが、今回は K です。Kは、KDE関係が多いようです。そのほかに、kubernetes や kopano というツール群のファイルもかなりあります。

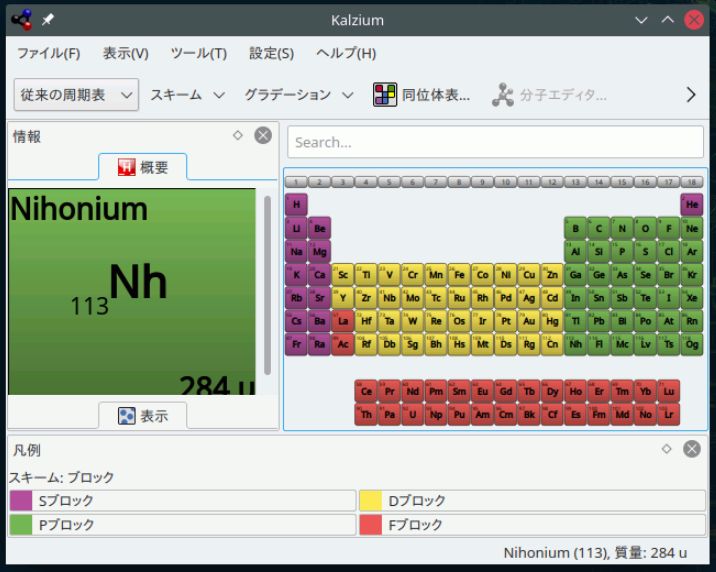

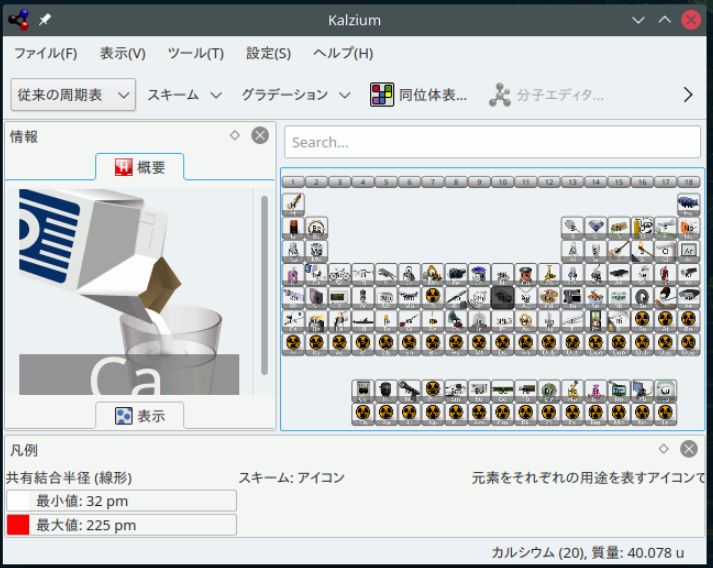

パッケージ名 kalzium

元素データの概要を表示することも出来ます。

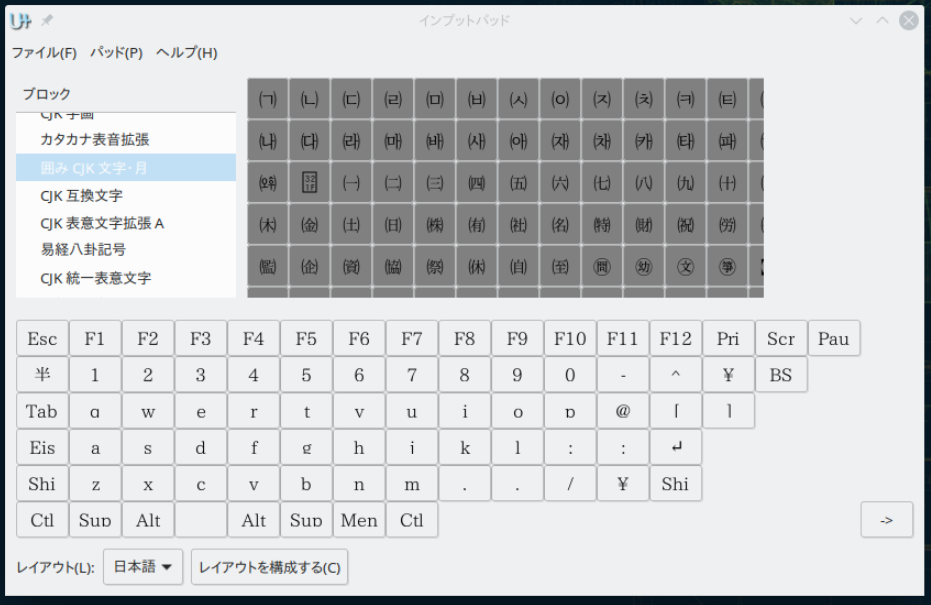

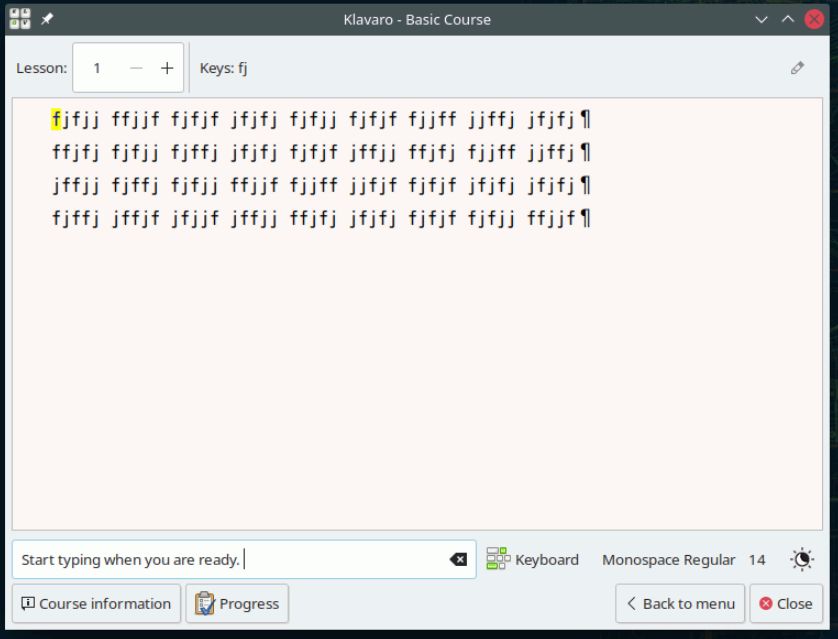

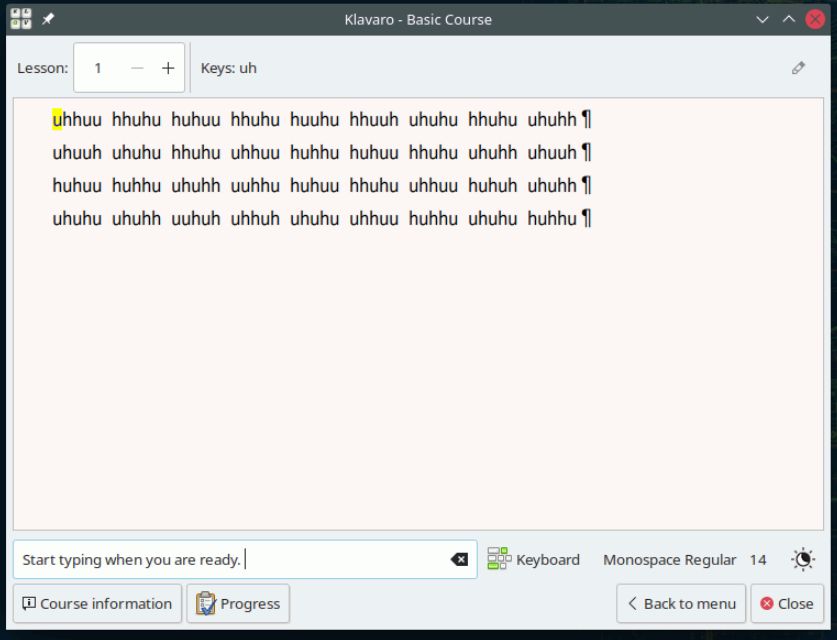

パッケージ名 klavalo

日本語キーボードにも対応しています。特殊記号の位置が正しい場所に来ます。

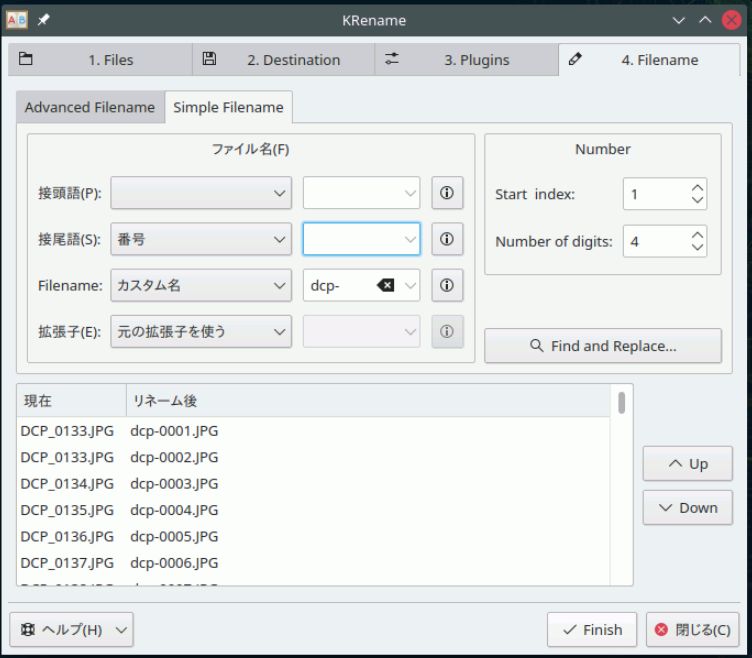

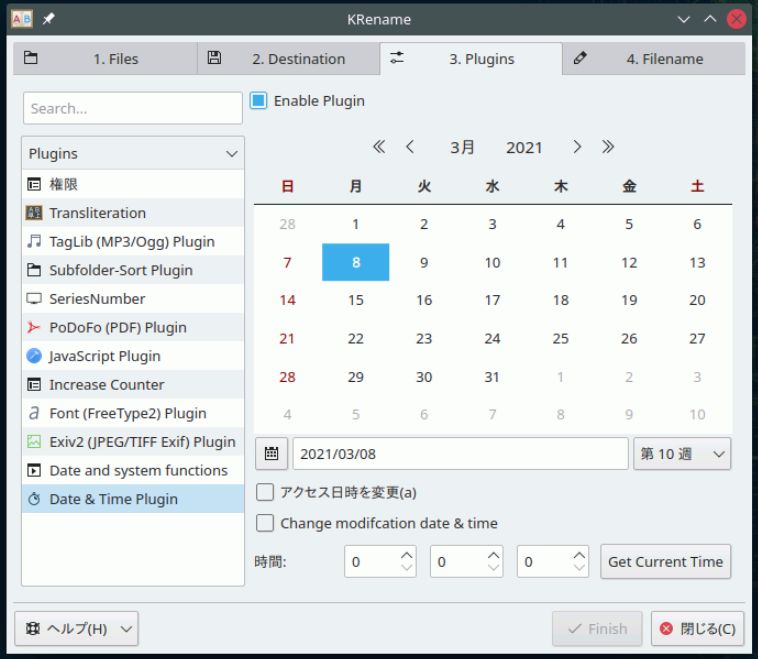

パッケージ名 krename

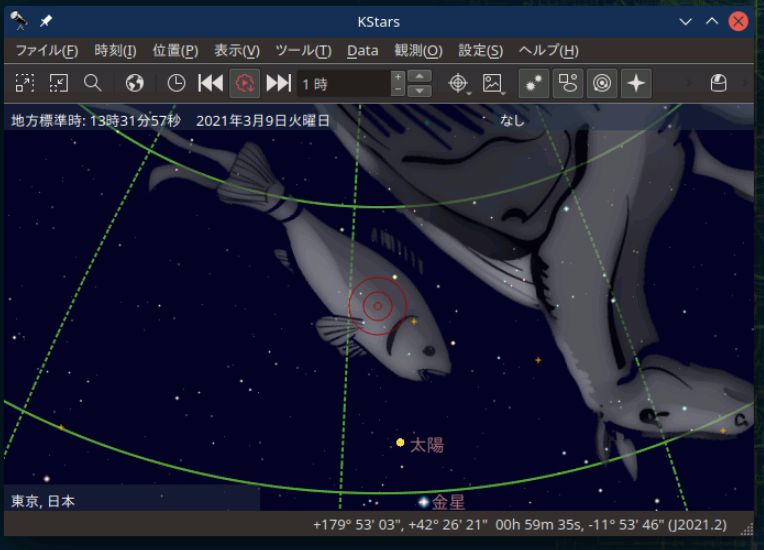

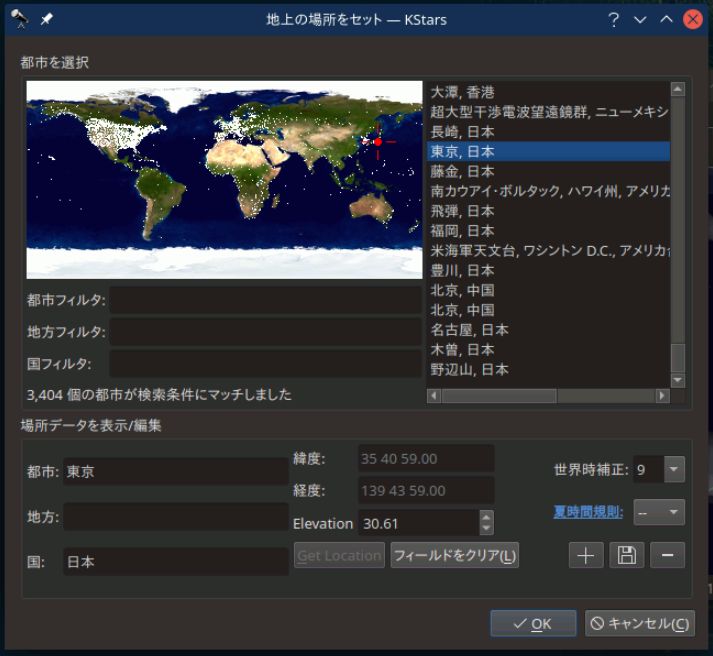

パッケージ名 kstars

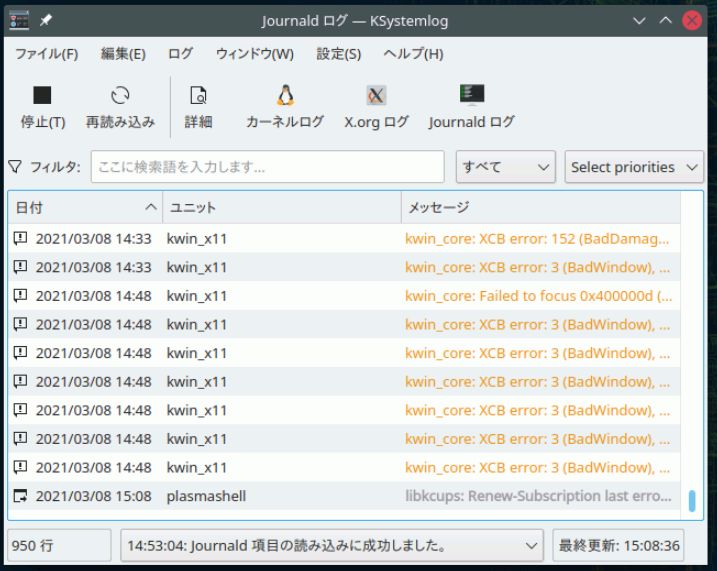

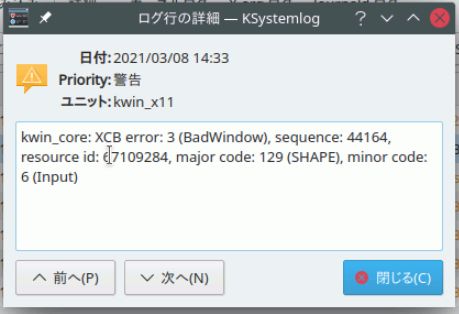

パッケージ名 ksystemlog

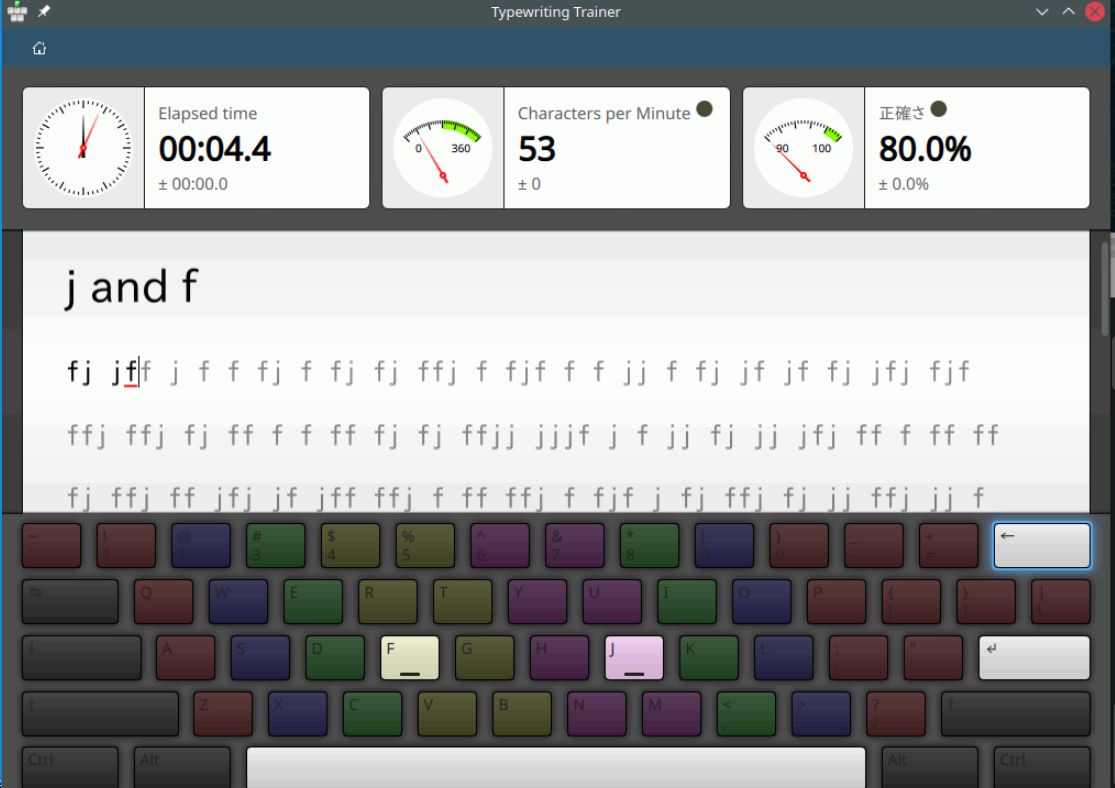

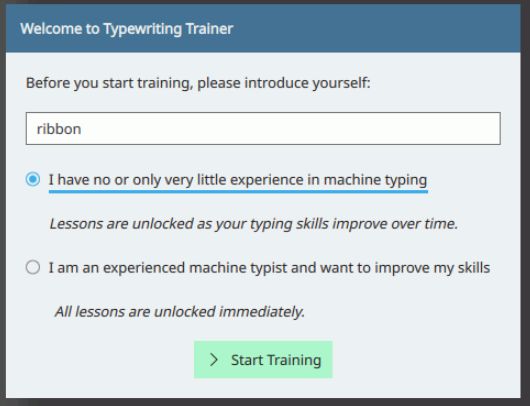

パッケージ名 ktouch

Category

openSUSE ,

Tips ,

その他 ,

デスクトップ |

受け付けていません

By ribbon @

2021-03-15 09:28

前回 は I でしたが、今回は X です。

パッケージ名 xfishtank

パッケージ名 xpra

Category

openSUSE ,

Tips ,

その他 |

受け付けていません

By ribbon @

2021-03-14 08:37

前回 は W でしたが、今回は I です。

パッケージ名 i18nspector

% i18nspector ./jm/jm/manual/util-linux/po4a/man8/lsblk.po

I: ./jm/jm/manual/util-linux/po4a/man8/lsblk.po: boilerplate-in-initial-comments 'Copyright (C) YEAR Free Software Foundation, Inc.'

I: ./jm/jm/manual/util-linux/po4a/man8/lsblk.po: boilerplate-in-initial-comments 'This file is distributed under the same license as the PACKAGE package.'

I: ./jm/jm/manual/util-linux/po4a/man8/lsblk.po: boilerplate-in-initial-comments 'FIRST AUTHOR <EMAIL@ADDRESS>, YEAR.'

P: ./jm/jm/manual/util-linux/po4a/man8/lsblk.po: no-language-header-field

I: ./jm/jm/manual/util-linux/po4a/man8/lsblk.po: unable-to-determine-language

W: ./jm/jm/manual/util-linux/po4a/man8/lsblk.po: boilerplate-in-project-id-version 'PACKAGE VERSION'

W: ./jm/jm/manual/util-linux/po4a/man8/lsblk.po: no-report-msgid-bugs-to-header-field

W: ./jm/jm/manual/util-linux/po4a/man8/lsblk.po: boilerplate-in-last-translator 'FULL NAME <EMAIL@ADDRESS>'

E: ./jm/jm/manual/util-linux/po4a/man8/lsblk.po: inconsistent-trailing-newlines msgid 'B<lsblk> lists information about all available or the specified block devices. The B<lsblk> command reads the B<sysfs> filesystem and B<udev db> to gather information. If the udev db is not available or lsblk is compiled without udev support than it tries to read LABELs, UUIDs and filesystem types from the block device. In this case root permissions are necessary.'ちなみにファイルの最初の所は

# SOME DESCRIPTIVE TITLE

# Copyright (C) YEAR Free Software Foundation, Inc.

# This file is distributed under the same license as the PACKAGE package.

# FIRST AUTHOR <EMAIL@ADDRESS>, YEAR.

#

msgid ""

msgstr ""

"Project-Id-Version: PACKAGE VERSION\n"

"POT-Creation-Date: 2020-09-20 15:12+0900\n"

"PO-Revision-Date: 2020-10-10 18:04+0900\n"

"Last-Translator: FULL NAME <EMAIL@ADDRESS>\n"

"Language-Team: Linux JM project <linuxjm-discuss@lists.osdn.me>\n"

"Language: \n"

"MIME-Version: 1.0\n"

"Content-Type: text/plain; charset=UTF-8\n"

"Content-Transfer-Encoding: 8bit\n"となっているので、言語の指定が無いなどを指摘しています。

パッケージ名 icmpinfo

# icmpinfo -vv

icmpinfo: Icmp monitoring in progress...

Mar 2 11:38:44 ICMP_Echo < 192.168.3.11 sz=2008(+20)

Mar 2 11:38:45 ICMP_Echo < 192.168.3.11 sz=2008(+20)

Mar 2 11:38:46 ICMP_Echo < 192.168.3.11 sz=2008(+20)

Mar 2 11:38:47 ICMP_Echo < 192.168.3.11 sz=2008(+20)

Mar 2 11:38:48 ICMP_Echo < 192.168.3.11 sz=2008(+20)

Mar 2 11:38:50 ICMP_Echo < 192.168.3.11 sz=2008(+20)

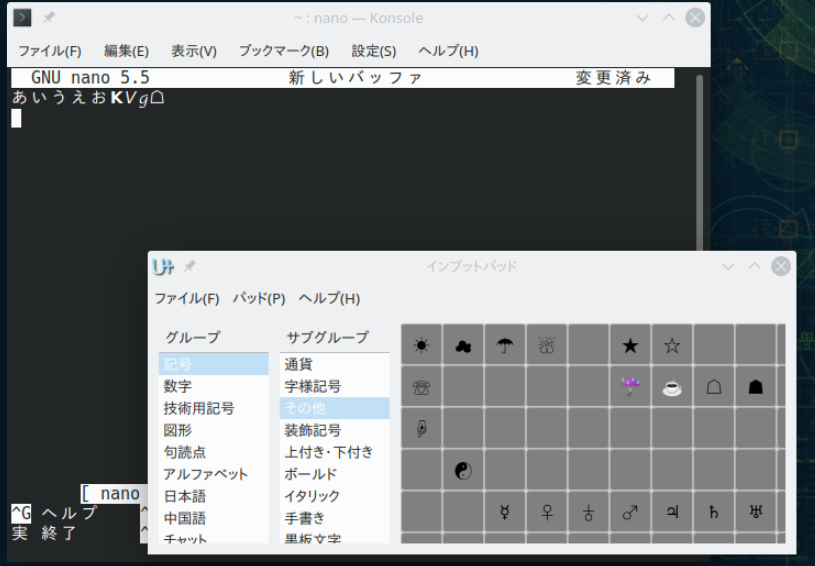

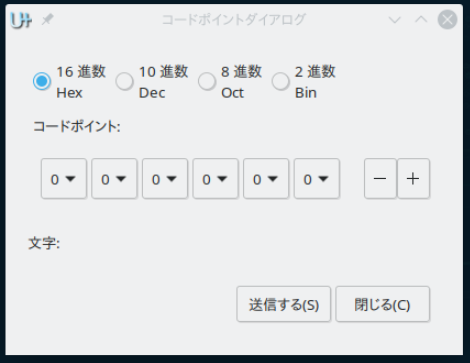

パッケージ名 input-pad

Category

openSUSE ,

Tips ,

その他 |

受け付けていません

By ribbon @

2021-03-13 22:57

openSUSE のパッケージを YaST からインストールするとき、そのパッケージの説明が表示されます。ただ、残念ながら、その多くは英文のままです。パッケージの多くは OS インストール時に自動的にインストールされてしまいますので、説明文を読むことはないのですが、後から個別にインストールする場合には、日本語の説明文があるとわかりやすいですね。

パッケージ名 wkhtmltopdf

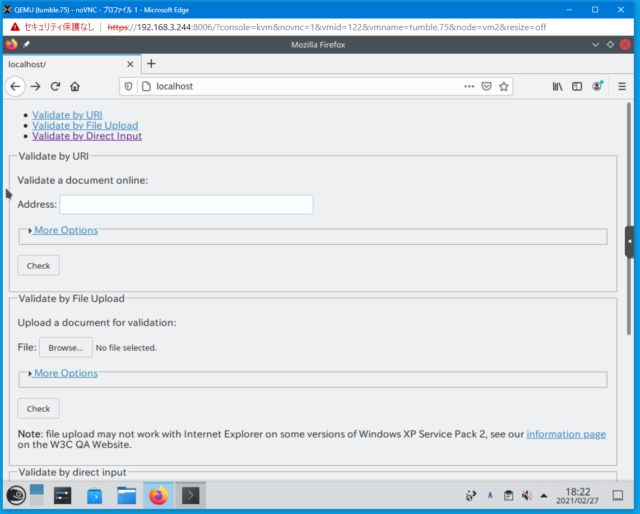

パッケージ名 w3c-markup-validator

LoadModule access_compat_module /usr/lib64/apache2/mod_access_compat.so

が、やっぱりエラーとなります。原因は簡単で、/etc/sysconfig/apache2 の中にロードするモジュール一覧を記述するところがあり、そこに、access_compat という文字列を追加しなければならないのでした。

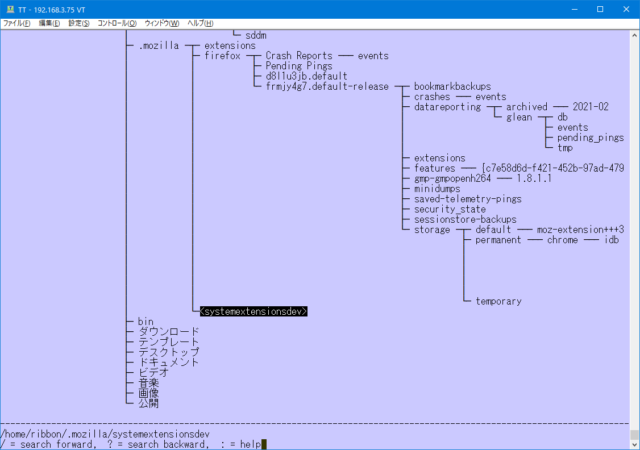

次に、データの準備をします。w3c-markup-validation は /srv/www/w3c-markup-validation と言うディレクトリにデータをおいてくれます。今回はサクッとテストするので、これを /srv/www と置き換え(ディレクトリを1つ下げてディレクトリ名を入れ替え)てみました。これでブラウザを使ってアクセスしてみると動きました。

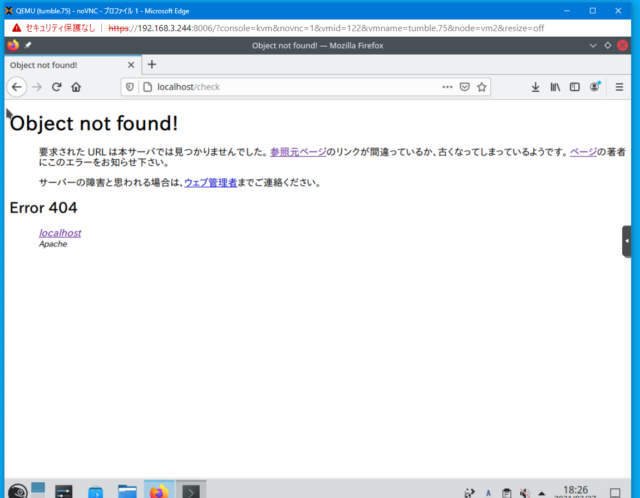

が、テストしてみるとやはり駄目です。

もう少し apache の設定ファイルに調整が必要なようです。

パッケージ名 watchman

https://kore1server.com/260/ファイル監視のwatchman

パッケージ名 wcd

ここまではいい感じでした。

パッケージ名 wdiff

% wdiff COPYING COPYING2 | head

のように、差分を表示してくれます。

https://fumiyas.github.io/2013/12/12/jwdiff.sh-advent-calendar.html

https://github.com/fumiyas/home-commands/blob/master/jwdiff

mecab を使うところがポイントですね。

https://github.com/hisashim/docdiff

パッケージ名 whohas

Couldn't fetch "http://dl.fedoraproject.org/pub/fedora/linux/releases/26/Everything/x86_64/os/Packages/w/". Giving up.

という感じで表示されます。検索は、各ディストリビューションの検索サイトを使って行い、その結果を表示するということをやっています。そのため、似たようなパッケージなども表示されるときがあります。複数のバージョンが表示されるときもあります。

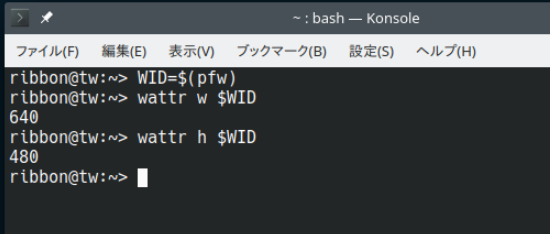

パッケージ名 wmutils

以下の機能が用意されています。

chwb - change window's borderchwso - change window's stacking orderignw - ignore/unignore windowkillw - kill windowslsw - list windowsmapw - map/unmap windowspfw - print focused windowwattr - show window's attributeswmp - move the mouse pointerwmv - move a windowwm_wtf - focus a windowwrs - resize a windowwtp - teleport a windowスクリプトなどでウィンドウの制御をするときには便利に使えそうです。

Category

openSUSE ,

Tips ,

その他 |

受け付けていません

By ftake @

2021-02-28 23:12

openSUSE Leap 15.2 の Raspberry Pi では Bluetooth が使える状態になっていません。SLE の Raspberry Pi Quick Start に書かれている次のコマンドで初期化する必要があります。

https://documentation.suse.com/sles/15-SP1/pdf/art-rpiquick_color_en.pdf

hciattach /dev/ttyAMA1 bcm43xx 921600

hciconfig hci0 up

このコマンドを実行することでファームウェアが読み込まれ、Bluetooth が使えるようになります。

Category

openSUSE |

受け付けていません

By ftake @

2020-12-25 23:41

今年も openSUSE Advent Calendar に参加頂きありがとうございました。

最終日は今年1年を振り返っていきたいと思います。

今年最初のイベントは1月3日の京都での新年会&もくもく会でした。続いて4日に東京での新年会でした。このときはこんな状況になるとも知らず、オフラインでの開催でした。

新年会以降、国内でも COVID-19 の感染者数が増え始め、今年のイベントはストップ。9年ぶりに都内に戻るはずだった OSC 東京も中止になってしまいました。

4月は OSC Online/Spring に参加。2月のOSCで発表予定だった Snapper を有効にしたファイルサーバーの話 をしました。初のオンラインイベントにもかかわらず、Remo を使ったバーチャル展示にも挑戦しましたが(枠は XDDC)、こちらはちょっと時代がまだ追いついていない感じでした。

5月は OSC Nagoya/Online に出展。川上さんが「Dockerで始めるネットワーク実験入門 」について話してくれました。

openSUSE Leap 15.2 の Release Party はなんとかオンライン開催しました。昼間から乾杯して、15.2のリリース情報を眺めて、修太さんがセキュアブートの話をしてくれました。

8月の OSC 京都は「あつまれ!openSUSEユーザーの森 」。京都でこのタイトルは流石に事務局に何か言われるんじゃないだろうかと言う声もありましたが、このままのタイトルになりました。ユーザー会のメンバーがどのように openSUSE を使っているかを紹介するという新しいスタイルのセミナーでした。

うちだけではないようですが、OSC のブースはユーザ会の出展モチベーションの大きな割合を占めていて、展示がないことで OSC 東京はスキップしてしまいました。このまま今年の OSC はおしまいとなりそうでしたが、12月、ODC は XDDC として春に開催予定であったディストリビューション大集合 を開催し、openSUSEも参加しました。

来年に向けて

今年は1年間を通して Geeko Magazine を出しませんでした。コミケも2回ともなくなってしまいましたし、技術書典や OSC などのオフラインでの頒布機会もありませんでした。

来年は GW に開催される予定の C99 に申し込んでいます。もしスペースを確保できれば、久しぶりの新刊を出すことができそうです。

イベントは当面オンラインになるかと思います。ユーザ会の単独イベントはどれくらい行うかは決めていませんが、メンバーは OSC はもちろん、小江戸らぐ などオンラインイベントにも出没していますので、ぜひ、参加してみて下さい。

Category

openSUSE |

受け付けていません

いくつかコースは予め用意されています。

いくつかコースは予め用意されています。