By ribbon @

2022-01-13 15:50

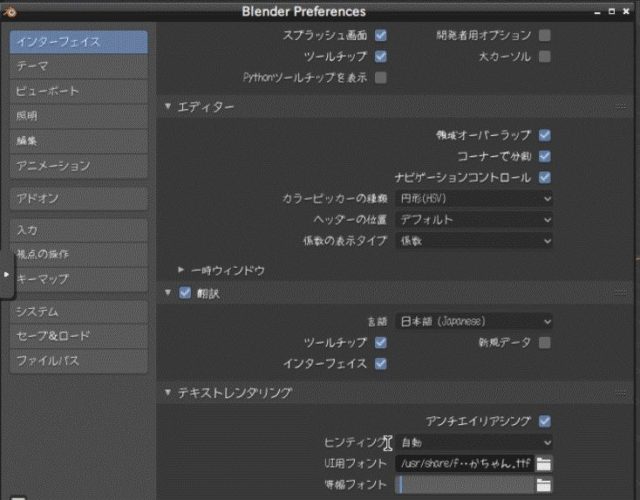

openSUSE にはパッケージで Blender が提供されています。しかし、起動時には英語のメッセージが表示されます。これを日本語化するには以下のようにします。

Edit->Preferences 画面を開き、 Text Renderning の所を開き(三角マークを

Category

openSUSE ,

Tips ,

デスクトップ |

受け付けていません

By ftake @

2021-12-26 21:50

この記事は openSUSE Advent Calendar の25日目です。

今年も openSUSE Advent Calendar にご参加頂きありがとうございました。みなさん忙しかったからか、今年は13日目で力尽きてしまいました。

最終日は openSUSE 関連の活動を振り返ってみようと思います。

1〜5月

うーん。何かを行った記録がありません。15.3 向けの開発をしていたかもしれません。

6月

openSUSE Leap 15.3 がリリースされました。今年はリリースパーティーも mini Summit もできなかったので、来年はしたいですね。

8月

openSUSE.Asia Summit をオンラインで開催しました。もともとは昨年にインドで開催する予定でしたが、インドチームによるオンライン開催になりました。

https://events.opensuse.org/conferences/oSAS21

8月末に開催された Open Developers Conference (ODC) では、Cross Distro Developers Camp の枠で Leap 15.3 とリリースモデルの話をしました。

https://speakerdeck.com/ftake/opensuse-leap-15-dot-3-toririsumoderufalsehua

9月〜11月

同じく活動の記録が…。

12月

今年も Advent Calendar を作成しました。序盤は勢い良くスタートしましたが…途中でばったり力尽きてしまった感じになってしまいました。

大晦日には Geeko Magazine Special Edition を久しぶり発行します。2年ぶりとは思えないページ数になっています。オンラインイベントが続くため、頒布機会がなかなか確保できなさそうですが、機会があればお手にとって見たください。

来年は?

今年は仕事が忙しく、Mozc の最新バージョンへのアップデートなど、いろいろやりかけになってしまいました。なんとか時間を取れるようにしたいなと思います。

Category

openSUSE |

受け付けていません

By ftake @

2021-12-19 22:43

openSUSE Advent Calendar の 19日目です。今年はすっかり力尽きてしまいました。クリスマス前にはもう少し投稿できるようにしたいと思います。

2年ぶりの Geeko Magazine Special Edition を発行します。最初の頒布はコミックマーケット C99 で、スペースは 2日目 東テ14b です。今年のコミックマーケットは事前チケットや、ワクチン接種証明書または PCR 検査結果が必要ですので、参加される方はご注意下さい。

今回の記事は次の通りです。久しぶりにも関わらず、例年通り集まりました。

SLE とパッケージがバイナリレベルで同じに!openSUSE Leap 15.3 リリース これは使える!?パッケージの説明一覧から見つけた面白そうなソフトウェアはこれだ!? OmegaT + TexTra で、Weblate による packages の説明を翻訳 マニフェストデバッグから入る Kubernetes 入門 小説: 女子高生アイドルがギーコと戯れる忙しい日々 コミックマーケット以降の頒布機会は未定です。当面 OSC はオンラインの予定ですので、どうするか検討します。

Category

Geeko Magazine ,

openSUSE |

受け付けていません

By ribbon @

2021-12-12 00:06

この記事は openSUSE Advent Calendar の12日目です。

タブレットPCには色々なものがあります。その中で、WindowsタブレットPC は比較的 Linux をインストールしやすいものの1つです。ただ、タブレット固有のハードウェアなどがあり、一部の機能が動かないこともあります。たまたま、タブレットPC の余剰品を払い受けたので、ものは試しに openSUSE をインストールしてみることにしました。なお、できるだけ新しいもののほうがインストール出来る可能性が高くなるため、 Thumbleweed をインストールすることにします。

対象機種

インストール対象の機種は NECパーソナルコンピュータ製の PC-HZ100 です。モバイルPentium、4Gメモリ、64G SSDというものです。2007年1月製です。

https://shop.nec-lavie.jp/navigate/products/pc/161q/01/lavie/hz/spec/index02.html

非常に軽く、携帯にはもってこいの10インチタイプ。しかもFull HD 画面です。キーボードは2種類あり、カバーを兼ねた、へなへなのキーボードと、バッテリや増設ポート、増設バッテリを含むちゃんとしたキーボードです。どちらもキーボードとしては同じように動作します。今回は、後者の方を使いました。というのは、ブートするためのUSBストレージを刺す口が本体にはないのですね。Type-C の口が一つしかないので。

動作状況

結論から先に言うと、動きました。インストールも何も問題ありませんでした。ただ、元のOS(Windows 10)は UEFI でインストールされていたので、openSUSE もUEFI モードでのインストールとなります。

HZ-100 はWindows 11 が動かないマシンなので、あと3年の寿命です。openSUSE であれば、その後も使えますので、お手軽持ち運びタブレットにはよいかもしれません。

Category

openSUSE ,

Tips ,

その他 |

受け付けていません

By ftake @

2021-12-10 00:00

みなさんは KDE のグローバルメニューを使ってますか? グローバルメニューは KDE Plasma のアップレットで、アクティブなウインドウのメニューが表示されます。画面上端にパネルを置いて、そこにこれを配置することで、macOS 風の UI を実現できます。

しかし、このグローバルメニューですが、時々不安定になり、アプリケーションによっては表示されなくなったりすることがあります。

同じようにアクティブウインドウのメニューを表示できるアップレットに Window AppMenu というものがあり、こちらであれば問題が起きないことがあります。困ったときは試してみてください。https://github.com/psifidotos/applet-window-appmenu

インストール方法はそんなに難しくはなく、Installation.md に書かれている以下のパッケージと

sudo zypper in -y xrandr cmake make gcc gcc-c++ extra-cmake-modules libqt5-qtbase-devel libqt5-qtdeclarative-devel libKF5WindowSystem5 plasma-framework-devel libSM-devel libqt5-qtx11extras-devel libkdecoration2-devel kconfigwidgets-devel kwidgetsaddons-devel kdeclarative-develこのあたりを追加でインストールしました

sudo zypper in kwayland-devel plasma5-workspace-devel plasma5-addons-devel kitemmodels-develあとは install.sh を実行するとインストールされ、パネルに Window AppMenu を追加できるようになります。

Category

openSUSE ,

デスクトップ |

受け付けていません

By ribbon @

2021-12-07 00:06

この記事は openSUSE Advent Calendar の7日目です。

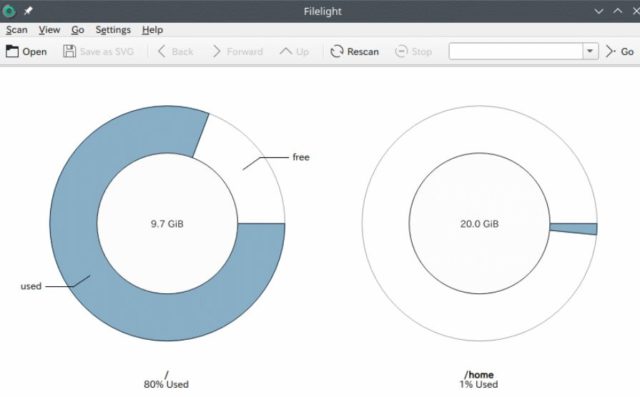

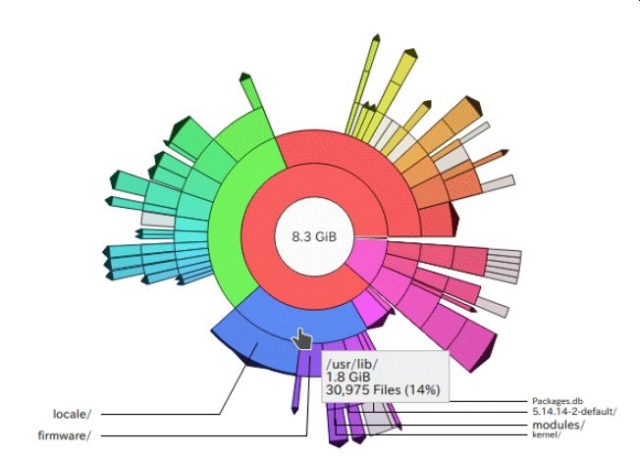

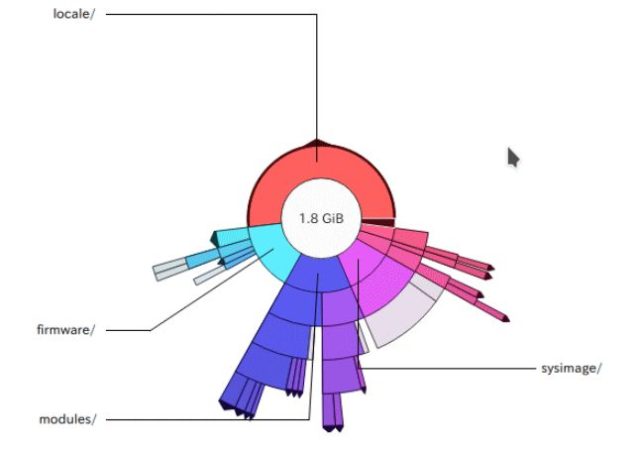

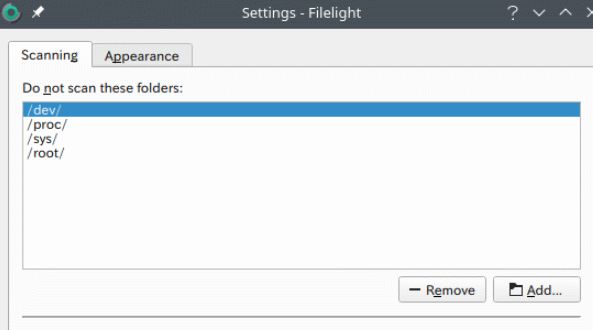

今回は filelight を紹介します。

filelight はグラフィカルにファイルの使用量を表示するツールです。KDE 環境が必要です。起動すると、以下のように、おそらくマウントポイント単位でディスクの使用状況をドーナツ状のグラフで表示します。

色が付いているところをクリックすると、その部分をドリルダウンして詳細を表示していきます。

また、特定のディレクトリについては調査対象外とすることもできます。既定では、/dev,/proc,/sys,/root が除外対象になっています。

そのほかにも、注目しているところをズームインしたり、画像を SVG 形式で保存できる機能もあります。

なお、filelight は、Windows 版もあります。Microsoft Store で入手が可能です。

Category

openSUSE ,

Tips ,

デスクトップ |

受け付けていません

By ribbon @

2021-12-06 00:29

この記事は openSUSE Advent Calendar の6日目です。

通常、root になって、 poweroff コマンドを投入すると、システムはシャットダウン動作を行い、電源を落として停止します。しかし、第四世代 Intel CPU の場合、poweroff コマンドで一度電源断まで行ったのち、数秒後に再起動してしまいます。少なくとも手元の i3-4130T、i5-4200M ではこの現象が発生します。 linux /vmlinuz-........ xhci_hcd.quirks=0x2000

のように、パラメータを追加する必要があります。

第四世代 Intel CPU を使ったマシンは、今から7-8年くらい前のもので、少々古いマシンではありますが、使い方によってはまだまだ使えます。もしもなぜか再起動してしまうという現象にお悩みの場合には上記のパラメータを試してみてください。

Category

openSUSE ,

Tips ,

サーバ ,

その他 ,

デスクトップ |

受け付けていません