By ftake @

2021-05-08 12:06

この記事は小江戸らぐ 5月のオフな集まり の発表ネタです。

2回目の夏を迎えるに当たり、自宅ファイルサーバーの熱とファンの音が気になり、モニタリングしてみることにしてみました。今回は他の用途でも興味があった Grafana を使ってみました。Grafana は CPU 使用率やメモリ使用量といったハードウェアから、データベースやアプリケーションの性能といった様々なメトリクスを可視化・分析するための Web アプリケーションです。インタラクティブに操作できたり、かっこいい見た目だったりで、最近よく見かけます。

小江戸らぐ向け注記: よくカロスさんの発表に出てきます。K8s のクラスタやラズパイの環境センサーの表示で使っていますね。

Grafana Cloud

今回はちょっと横着して、Grafana の SaaS である Grafana Cloud を使いました。Grafana といえば、多くの場合、メトリクス収集と時系列データベース機能を持つ Prometheus と組み合わせ、これら2つをどこかにインストールして使います。Grafana Cloud では Grafana 本体と Prometheus のデータベース部分は Grafana Cloud で動いているものを使うことができます。データの収集は Prometheus からデータベース部分などを簡略化した Grafana Agent で収集できます。

気になるお値段ですが、Free プランがあります。メトリクスの保持期間は2週間というのがポイントになりますが、ちょっと試して見るには十分です。無料プランの主なスペックはこんな感じです:

10,000 系列(種類)までの Prometheus または Graphite のメトリクス 50 GB のログ 14日間のメトリクスとログの保持期間 3人までのチームメンバー アカウントを作るためにクレジットカードなどの情報は特に必要ありません。 Grafana Cloud のページでアカウント作成に進み、GitHub などの SSO でログインすればすぐ準備完了です。

メトリクス収集

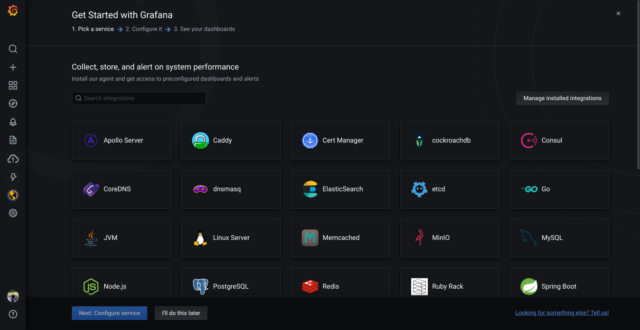

次に、メトリクスの収集を始めましょう。雷のアイコン(⚡) > Walk through をクリックすると、スクリーンショットのように Grafana Cloud がサポートしているプラットフォームのメトリクス収集を簡単にセットアップできるガイドが用意されています。今回は Linux Server を使用します。Prometheus では Node Exporter と呼ばれているものです。

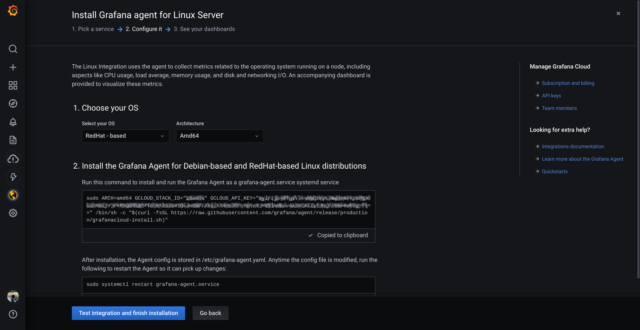

Linux Server をクリックすると、セットアップするためのスクリプトが表示されます。「Choose your OS」には openSUSE が見当たりませんが、「RedHat – based」で OK です。Go言語で実装されたアプリなので、システムライブラリにほとんど依存していません。

あとは、その下に表示されたスクリプトを実行すれば OK です。Grafana Agent の RPM のインストールと設定ファイルの作成、起動まで一気に行われます。セットアップが終わると、最初から用意されているダッシュボードに収集した情報が表示されます。(datasource で grafanacloud-xxxx-prom を選択)

ダッシュボードの作成

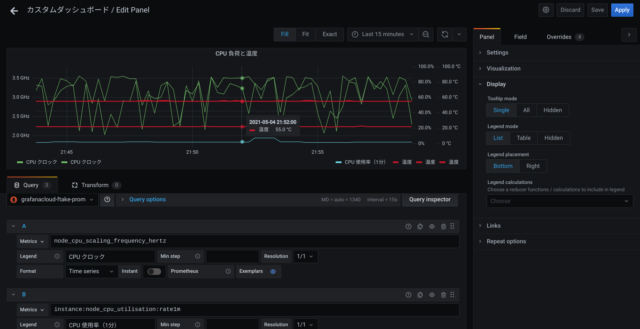

もちろん、ダッシュボードを自分で組み立てることもできます。ここではパネルを配置し、Visualization を Time Series にして次を追加してみました。収集されているメトリクスの一覧がドロップダウンメニューに表示されるので、ここからそれっぽいものを選んで追加することができます。

node_cpu_scaling_frequency_hertz instance:node_cpu_utilisation:rate1m node_hwmon_temp_celsius 各系列のスタイルや、単位、Y軸の設定は、ちょっとわかりにくいですが Overrides タブで系列を選んで個別に設定できます。

このファイルサーバーは普段ほとんどアイドル状態なのですが、CPU クロックが思った以上に落ちていないことが分かりました。ファンコントロールのターゲット温度が45℃設定なのですが、55℃くらいをキープしているようです。

おわりに

Grafana Cloud を使って自宅ファイルサーバーの監視を簡単にしてみました。そして Grafana Agent が CPU 時間を他と比較して使ってしまっていますので、場合によっては収集する項目を減らすなどを考えたほうが良いかもしれません。

Category

openSUSE ,

サーバ |

受け付けていません

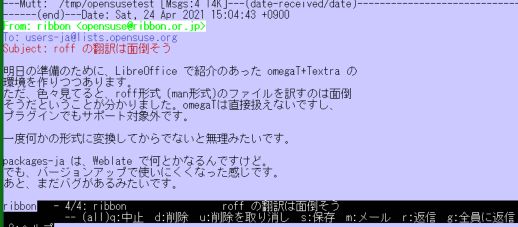

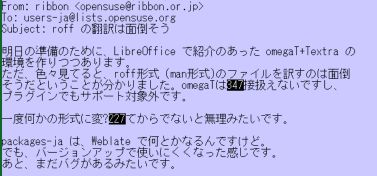

By ribbon @

2021-05-06 17:58

前回は S でしたが、今回は A です。

パッケージ名 ansifilter

ただし、漢字についてはうまくいかない場合がかなりあります。また、HTML 変換については、エスケープシーケンスを落として変換、すなわち、色とかの情報がまるまる落ちて変換されます。ここはちょっと惜しいところです。

パッケージ名 arping2

# ping -c 4 192.168.A.BB

PING 192.168.A.BB (192.168.A.BB) 56(84) bytes of data.

--- 192.168.A.BB ping statistics ---

4 packets transmitted, 0 received, 100% packet loss, time 3058ms

tw:~ # arping2 -c 4 192.168.A.BB

ARPING 192.168.A.BB

42 bytes from a6:3a:xx:yy:zz:98 (192.168.A.BB): index=0 time=487.929 usec

42 bytes from a6:3a:xx:yy:zz:98 (192.168.A.BB): index=1 time=362.456 usec

42 bytes from a6:3a:xx:yy:zz:98 (192.168.A.BB): index=2 time=356.881 usec

42 bytes from a6:3a:xx:yy:zz:98 (192.168.A.BB): index=3 time=389.354 usec

--- 192.168.A.BB statistics ---

4 packets transmitted, 4 packets received, 0% unanswered (0 extra)

rtt min/avg/max/std-dev = 0.357/0.399/0.488/0.053 msたとえば、Windows Server の既定状態のような機器との疎通を確認するには便利に使えそうです。

Category

openSUSE ,

Tips ,

デスクトップ |

受け付けていません

By ftake @

2021-05-02 22:57

自宅サーバーをセットアップした際に、すべてを HDD にインストールしていたのですが、今回、/home と /boot、過去のスナップショットデータ以外を SSD に引っ越しました。このとき、Btrfs のサブボリュームとしての引っ越しをしてみました。

最初に openSUSE の Btrfs のサブボリューム構成についておさらいです。Snapper が有効化された状態のサブボリューム構成は次のようになっていました。Btrfs の / には @ というサブボリュームが1つだけあります。@ の中にマウントしたシステムの / にあるディレクトリに対応したサブボリュームがあります。ちなみに /@ が / としてマウントするのではなく、それぞれのサブボリュームごとに /etc/fstab でマウントしています(例: /@/home が /home)。Snapper を使用している場合は 1 番目のスナップショットが現在の / です。

以下のリストに無い、/@/.snapshots/1/ や /@/boot/grub2/ はサブボリュームではなく、その上にあるサブボリューム内のディレクトリです。

/@

/@/.snapshots

/@/.snapshots/1/snapshot

略

/@/.snapshots/61/snapshot

/@/boot/grub2/i386-pc

/@/boot/grub2/x86_64-efi

/@/home

/@/opt

/@/root

/@/srv

/@/tmp

/@/usr/local

/@/var

/@/var/lib/machines

さて、今回は /@/home と /@/boot/* を HDD に残し、その他を SSD に移動することにしました。パーティション全体であれば、dd で、ファイルレベルであれば rsync と色々な方法がありますが、今回は Btrfs のサブボリュームを他の Btrfs ファイルシステムに転送する btrfs send を使いました。

作ってみたスクリプトを先に貼り付けて、ポイントを個別に説明します。使い方はコピー元を /dev/sda1、コピー先を /dev/sdb1 とし、次のように使います。3番目の引数はスキップするサブボリュームのパターンです。/dev/sdb1 は mkfs.btrfs でフォーマットしてある前提です。$ btrfs-subvols-copy.sh /dev/sda1 /dev/sdb1 "@/home|@/.snapshots/[2-9][0-9]*|@/boot"

#!/bin/sh

set -eu

exclude=$3

# mounting root volumes

workdir=`mktemp -d`

echo "working directory is '$workdir'"

cd $workdir

mkdir src

mkdir dest

# ルートのサブボリュームをマウントマウントする

echo "mounting root subvolumes of src and dest"

mount -t btrfs -o subvol=/ $1 $workdir/src

mount -t btrfs -o subvol=/ $2 $workdir/dest

src=$workdir/src

dest=$workdir/dest

backup_date=`date -u +'%s'`

# サブボリュームの一覧を出力

for subvol in `btrfs subvolume list --sort=path $src | awk '{print $9}'`; do

echo -n ">> $subvol: "

if [[ $subvol =~ $exclude ]]; then

echo "matched to a exclude pattern, skipped"

elif [ -e $dest/$subvol ]; then

echo "the destination subvolume already exists, skipped"

else

echo "create readonly tmp snapshot"

tmpsnap=$subvol.tmpsnap

# スナップショットを作って送る

echo "creating a read-only temporary snapshot to send] $src/$tmpsnap"

btrfs subvolume snapshot -r $src/$subvol $src/$tmpsnap

echo "copying"

btrfs send $src/$tmpsnap | btrfs receive $dest/`dirname $tmpsnap`

# 送信用のスナップショットを消す

echo "deleting the temporary snapshot: $src/$tmpsnap"

btrfs subvolume delete $src/$tmpsnap

# .tmpsnap を外す

echo "renaming the copied subvolume"

mv $dest/$tmpsnap $dest/$subvol

# property を元のサブボリュームと同じにする

echo "copying subvolume properties"

for prop in `btrfs property get $src/$subvol`; do

btrfs property set $dest/$subvol ${prop/=/ }

done

echo "done"

fi

done

echo "unmounting src and dest"

umount $workdir/src

umount $workdir/dest

echo "cleaning up working directory"

rmdir src

rmdir dest

rmdir $workdir

まずは、送信元、先のボリュームのマウントです。

# ルートのサブボリュームをマウントマウントする

echo "mounting root subvolumes of src and dest"

mount -t btrfs -o subvol=/ $1 $workdir/src

mount -t btrfs -o subvol=/ $2 $workdir/dest

送信元と先をマウントするだけなのですが、注意点が1つあります。Btrfs では任意のサブボリュームを選んでマウントすることができますが、何も指定しないと / ではなく、デフォルトのサブボリューム(btrfs subvolume set-default で設定可能)がマウントされてしまいます。特に Snapper を使用していると、1番目の Snapper スナップショットがデフォルトになっていますので、明示的に subvol でマウントしたいサブボリュームの指定が必要です。

次に、送信元のサブボリュームのリストアップです。

# サブボリュームの一覧を出力

for subvol in `btrfs subvolume list --sort=path $src | awk '{print $9}'`; do

--sort=path を指定して、親ディレクトリを含むサブボリュームを先にリストし、サブボリュームのツリー構造の親サブボリュームとディレクトリを先にコピーするようにします(存在しないとエラーになってしまいます)。

次に送信するところです。

# スナップショットを作って送る

echo "creating a read-only temporary snapshot to send] $src/$tmpsnap"

btrfs subvolume snapshot -r $src/$subvol $src/$tmpsnap

echo "copying"

btrfs send $src/$tmpsnap | btrfs receive $dest/`dirname $tmpsnap`

btrfs send コマンドを使ってコピーするのですが、送信できるのは読み取り専用のサブボリュームなので、一度スナップショットを読み取り専用で作成し、このスナップショットを送ります。コピーは btrfs send と btrfs receive のペアで行えます。サブボリュームの名前(パス)は送信元と同じものが作成されます。そのため、スナップショットの名前になってしまうので、あとで mv が必要でちょっと不便です(スナップショットを別のディレクトリに作成する方法もあり)。

注意が必要なことが1つあります。この送り方では Snapper のスナップショットを送れません。Snapper のスナップショットはスナップショット間で共通するデータを共有していますが、この方法ではこの共有が解けて複製されてしまいます。btrfs send のオプションにベースとなったスナップショットを指定し、差分だけを送る機能があるようなので、もう少し工夫すると実現できるかもしれません。

最後に、サブボリュームのプロパティのコピーです。

# property を元のサブボリュームと同じにする

echo "copying subvolume properties"

for prop in `btrfs property get $src/$subvol`; do

btrfs property set $dest/$subvol ${prop/=/ }

done

送信前に読み取り専用のスナップショットを作成していますので、読み取り専用を含めた、送信後サブボリュームのプロパティをもと同じに戻します。

Category

openSUSE ,

ファイルシステム |

受け付けていません